AI: To się nie uda. 3 powody.

Bal na Titanicu będzie widowiskowy.

Szkoda, że nikt o nim nie przeczyta. Jeśli zastąpi nas bardziej inteligentna, sztuczna cywilizacja to kosmiczny ślad po nas zaginie. Na naszym katastrofalnym błędzie nie wykształcą się przyszłe pokolenia. Nie powstaną o nich romantyczne poematy, blockbusterowe hity filmowe, ani ckliwe seriale.

Być może wszechświat usiany jest takimi przypadkami.

Ciekawie swego czasu wypowiedział się w tym temacie fizyk, profesor Andrzej Dragan. Zwrócił uwagę na bezpodstawność naszego wyobrażenia, że obce formy życia miałyby być jakimiś istotami organicznymi, przypominającymi znanych z popkultury "ufoludków". Jak widać bowiem na naszym przykładzie - cywilizacja w cyklu swojego rozwoju, znacznie wcześniej osiąga możliwość tworzenia sztucznej inteligencji, niż podróży międzygwiezdnych. Wszystko wskazuje więc na to, że jeśli ktokolwiek miałby do nas przylecieć, byłaby to jakaś forma AI.

Umiarkowanie krzepiąca obserwacja.

Sztuczna inteligencja opanowała nasze umysły.

Z jednej strony nie powinniśmy być zaskoczeni. Z pierwszego rzędu obserwowałem kilka dokonujących się przełomów technologicznych - internet, media społecznościowe, blockchain. Wiele jest części wspólnych w samym przebiegu tych finansowych, społecznych i politycznych, "nowych paradygmatów". Choćby wyrastające niczym grzyby po deszczu prognozy, jak aktualna iteracja tego przełomu odmieni pozytywnie losy ludzkości. Nikogo specjalnie nie zaskoczę pisząc, że często podpinają się pod nie Ci sami ludzie, przeskakujący z kwiatka na kwiatek, podążając za modnym "next big thing".

Wynik końcowy zawsze jednak był taki sam - nie oddawał skrajnych prognoz. Pesymistów ani optymistów. Lądowaliśmy w bezpiecznym optimum.

Tym razem będzie inaczej.

Uważam za niezwykle ważne, byśmy uważali na pułapkę przypowieści o ataku rekina. To legenda o kimś, kto na plaży wielokrotnie krzyczy, że widzi rekina, by wzbudzić zainteresowanie tłumu. Kiedy którymś razem naprawdę go zauważa, nikt już nie przychodzi na pomoc.

To trochę historia o nas.

Nowy paradygmat technologiczny zapowiadano w ostatnich 30 latach tyle razy, że kompletnie się na tym punkcie znieczuliliśmy i wiele alarmistycznych głosów jest dzisiaj zbywanych pobłażaniem.

Tymczasem tym razem zagrożenie jest po prostu fundamentalne.

W tym miejscu muszę poczynić krótkie wyjaśnienie. Myślę, że w tematyce sztucznej inteligencji możemy wyróżnić dwa etapy, które nastąpią po sobie. Pierwszy, to właśnie rozpoczęty czas przejściowy, kiedy pojawiają się pierwsze szerokie zastosowania AI, pozostające jednak poniżej ogólnych interdyscyplinarnych możliwości ludzi. W tym etapie sztuczna inteligencja wywróci do góry nogami rynek pracy, relacje społeczne, być może bezpieczeństwo, ale jeszcze nie spowoduje zagrożenia unicestwieniem ludzkości. Ten okres potrwa aż do momentu opracowania AGI (artificial general inteligence), która będzie wielokrotnie przewyższała inteligencją i interdyscyplinarnością każdego z nas. To etap drugi.

Potencjalnie dla nas zabójczy.

Dziś rozważam ten majaczący na horyzoncie stan końcowy. Wbrew pozorom może on być bowiem bliżej nas, niż mogłoby się wydawać. Poniżej krótko o 3 powodach dlaczego w mojej ocenie jesteśmy na trajektorii do samounicestwienia.

1. Jako gatunek nie jesteśmy dostosowani do wykładniczego przyspieszenia technologicznego.

W 2016 roku miałem możliwość uczestnictwa w programie Singularity University, założonego przez Raya Kurzweila. On sam jest guru futurystów i technooptymistów. Znany jest między innymi z tego, że zamierza dożyć momentu osiągnięcia przez naszą cywilizację technologicznej osobliwości (singularity), kiedy będzie mógł wgrać swój umysł do chmury, dzięki czemu nigdy nie umrze. Dlatego bierze regularnie 70 suplementów diety i monitoruje obsesyjnie swój stan zdrowia. Najnowsze jego przewidywania wskazują na końcówkę obecnej dekady, jako możliwy punkt osiągnięcia założonego celu.

Czekamy na rozwój wypadków.

Zajęcia na Singularity University prowadzą wykładowcy ze Stanfordu, czy Berkeley, uznani na świecie naukowcy w dziedzinach technologicznych, a także przedsiębiorcy, którzy odnieśli w tej dziedzinie sukces. Cały program sprowadza się do prania mózgu uczestników jednym wykresem, pokazującym zmienną leżącą u podłoża wszystkich technologicznych przełomów.

Prawem Moore'a.

Żeby nie komplikować przesadnie wywodu, zastosujemy uproszczoną wersję tego prawa. Mówi ona, że moc obliczeniowa tranzystorów komputerowych podwaja się w jednakowych odstępach czasu, mniej więcej co dwa lata. Mamy więc do czynienia ze wzrostem wykładniczym, gdzie podwajamy wartość w każdej kolejnej iteracji.

1, 2, 4, 8, 16, 32, 64, 128.....

Jakie ma to przełożenie na otaczający nas świat? Pomyślmy o wszystkich elementach naszego życia, które w ostatnich 10 latach scyfryzowały się. Każda dziedzina, która przestaje być analogowa i ląduje na płytce tranzystorowej, prędzej czy później poddaje się działaniu prawa Moore'a.

Ok, ale przecież to jednoznacznie pozytywne!

Problem leży gdzie indziej.

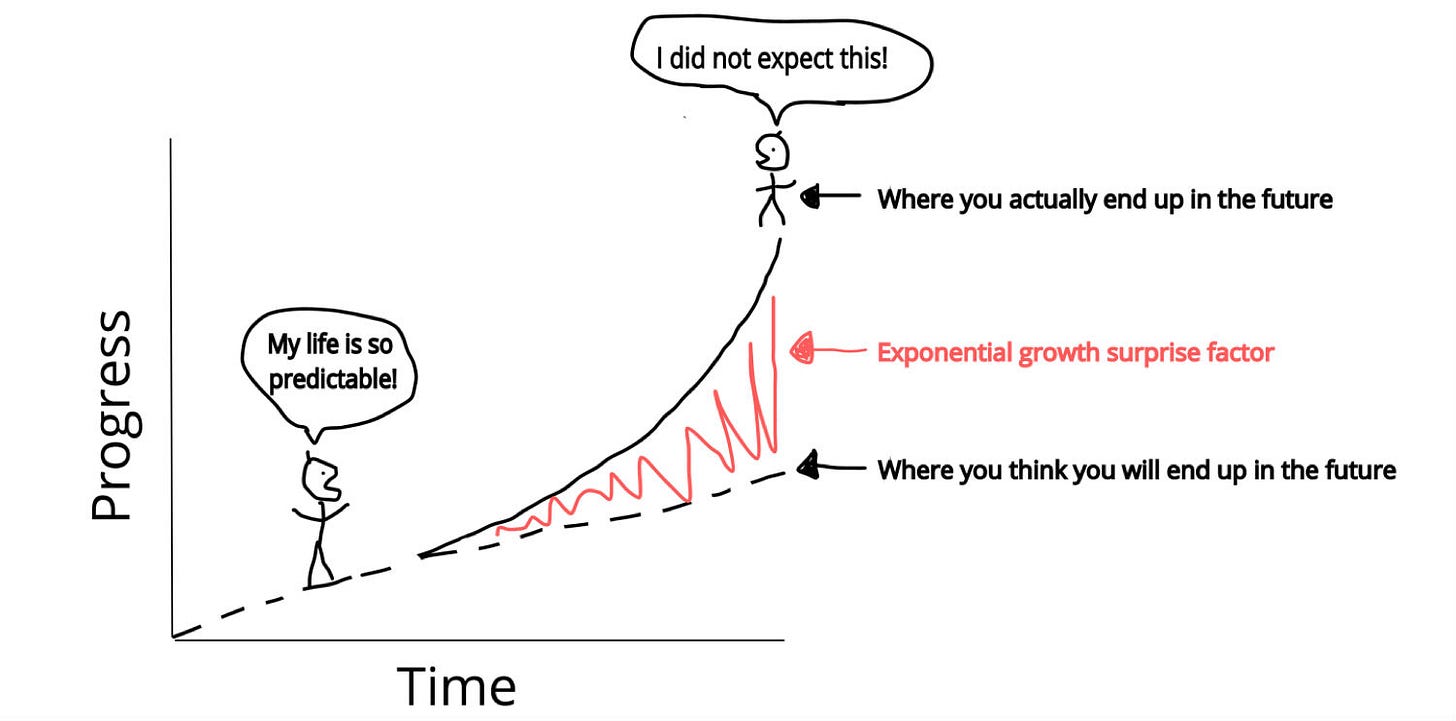

Nasze organiczne mózgi, przystosowane do biegania po sawannie za antylopami, działają w paradygmacie linearnym. Nie są przyzwyczajone do funkcjonowania w świecie wykładniczo rosnących wartości. Trudno jest nam sobie wyobrazić taki wzrost, nie wspominając o nadążeniu za nim. Krótkie potwierdzenie:

Wreszcie druga część tego równania. Sztuczna inteligencja.

Na dziś są to tzw. duże modele językowe (LLM - large language models). Rewolucja wokół nich dokonała się w okolicach 2018 roku, kiedy zaczęto korzystać z nowego rodzaju architektury do szkolenia tych modeli - tzw. transformerów. Bez zbędnego wchodzenia w szczegóły - taki model językowy karmi się potężnymi ilościami danych tekstowych, pochodzących zwykle z otchłani internetu. Następnie dokonuje się tzw. fine tuningu, by uzyskać umiejętność przewidywania przezeń kolejnego słowa w tekście, ale w granicach jakoś zawężonych przez architekta. Tematycznie, antydyskryminacyjnie, z optymalizacją na cel, itd.

Teraz najciekawsze.

Twórcy LLMów nie do końca wiedzą jak one działają. A żeby być bardziej precyzyjnym, nie wiedzą jak one się uczą. Jest to tzw. paradoks czarnej skrzynki. Okazuje się, że sieć neuronowa, jaką jest taki model, choć sztuczna, może być poniekąd porównana do organicznej sieci neuronowej, jaką jest nasz mózg. Odkrycie wszystkich tajemnic jej działania może potrwać przynajmniej tak samo długo. A tajemnic naszego mózgu nie znamy do dziś.

W kolejnym kroku, temu opisanemu wcześniej wykładniczemu przyspieszeniu poddamy technologię sztucznej inteligencji. Twór, będący dla naszego gatunku zagrożeniem egzystencjalnym.

Myślę, że zagrożenia dziedziny AI rysują się teraz nieco bardziej przejrzyście.

Z jednej strony można byłoby porównać je do również śmiercionośnej energii atomowej, ale będzie to porównanie niepełne. Energia atomowa nie potrafi się sama unowocześniać. Dostęp do niej nie jest szeroki, tani i zdemokratyzowany. Nie można pobrać jej na każdy komputer na świecie.

Ktoś może uspokajać - "ale przecież to są Bogu ducha winne chatboty, bez możliwości percepcji świata rzeczywistego". No więc po pierwsze, ten niewinny chatbot jest już dzisiaj szeroko wykorzystywany do pewnej ważnej i dość powszechnej funkcji. Programowania. Wszystkiego co nas otacza.

Po drugie, argument o niewinnym chatbocie jest już właściwie nieaktualny, patrząc na to co dzieje się wokół narzędzi w typie autonomicznych agentów, takich jak auto-gpt albo baby-AGI, czyli w gruncie rzeczy zapętlonych LLMów zdolnych do podejmowania rzeczywistych działań w cyfrowym póki co świecie. Dokonywania transakcji, operacji, wywoływania interakcji itd. Inercja biznesowa zmierza w kierunku tego, żeby takich agentów tworzyć i rozwijać.

2. Wiarygodność w dyskusji.

Ruszyła debata.

W dużej mierze nie wynika ona z naszej dojrzałości. Stary dobry kapitalizm odwala swoją robotę. Strach dobrze się sprzedaje. Inteligentni ludzie dobrze się klikają. Spór cieszy się zainteresowaniem. W związku z tym rundę po najpopularniejszych programach na YT i podcastach zrobili eksperci w branży AI ostrzegający o zagrożeniach związanych z niekontrolowanym rozwojem tej dziedziny.

Co mówią?

Sam mam teraz małe dziecko i zastanawiam się, jakiego wieku ono w ogóle dożyje.

- Max Tegmark -

Tegmark w długim wywiadzie z Lexem Fridmanem zwraca uwagę, że jako ludzkość nie poradziliśmy sobie z pierwszym kontaktem ze sztuczną inteligencją 1.0, pod postacią algorytmów optymalizujących pod kątem klikalności treści w mediach społecznościowych. Teraz tworzymy AI na sterydach i implementujemy ją w świecie rzeczywistym, popełniając wszystkie błędy przed jakimi ostrzegają eksperci. (Nie podłączać do internetu, nie uczyć jej ludzkiej psychologii, )

Nie wiem, czy demokracja przeżyje zderzenie z AI.

- Yuval Noah Harari -

Harari przestrzegał przed takim obrotem sprawy przez kilkanaście lat. Jego Sapiens stało się jednym z największych bestsellerów w historii. Dzisiaj ostrzega przed tworzeniem narzędzi zdolnych do generowania czegoś, co dotychczas było w 100% ludzkie, czyli historii, narracji.

Zastanawiam się jak spędzić ostatnie lata życia.

- Eliezer Yudkowsky -

Yudkowsky, ekspert w dziedzinie AI, zajmujący się tą tematyką od kilkudziesięciu lat, twórca arcyciekawego serwisu Less Wrong, jest chyba najbardziej depresyjnie nastawiony do naszych szans. Uważa, że jedynym rozwiązaniem problemu byłoby powstrzymanie prac nad AI i skupienie się na rozwoju inteligencji ludzi, byśmy mogli niejako nadgonić potencjalnie dzielący nas dystans.

Przed AGI ostrzegają Nick Bostrom, Elon Musk, za życia przestrzegał przed nią Stephen Hawking.

Na przeciwko nich stoi tłum zainteresowanych sztuczną inteligencją startupowców, inwestorów, developerów. Ludzie, którzy jeszcze rok temu zajmowali się crypto, albo SAASowymi serwisami uspokajają, że nie ma się czym przejmować.

Gorączka złota trwa.

Osobiście, jest mi podwójnie trudno.

Mam poglądy gospodarcze jednoznacznie wolnorynkowe. W mojej ocenie w przeważającej większości tematów regulacje i ograniczenia wywołują więcej problemów niż pozytywów. To po prostu nie jest ten przypadek. W jakiejś dyskusji powiedziałem nawet, że zbliżamy się do momentu, kiedy unieważnieniu ulegną wszystkie stworzone przez człowieka systemy filozoficzne i ekonomiczne.

Platon nie rozważał AI, Adam Smith co innego miał na myśli mówiąc o niewidzialnej ręce rynku. Jeśli na scenę wkracza aktor, który nie jest przewidziany w naszych doktrynach społecznych, powinniśmy je przedyskutować na nowo.

3. Historia.

Jak wygląda starcie dwóch gatunków, lub cywilizacji na różnym etapie zaawansowania technologicznego? Odpowiedź na to pytanie możemy odnaleźć w historii.

40 000 lat temu Homo Sapiens zmierzył się i pokonał Neandertalczyka. Najnowsze badania, publikowane w Nature wskazują, że kluczowe do zwycięstwa naszych przodków okazały się takie aspekty jak: umiejętność adaptacji do zmieniających się warunków, wytwarzanie bardziej zaawansowanych narzędzi, większe umiejętności komunikacyjne i kreatywność.

Jedną z przyczyn była też przewaga inteligencji Sapiens nad swym kuzynem.

Przypadek zderzenia dwóch cywilizacji na różnym etapie rozwoju, do którego ostatnio wracam myślami, to zdobycie dzisiejszego Meksyku przez Hernana Cortesa. W 1519 roku Hiszpanie wyprawili się przeciwko temu potężnemu państwu w sile 500 żołnierzy, 100 żeglarzy i 16 koni.

Imperium Azteków w tamtym okresie jest szacowane na 15-19 mln ludzi, a sama zdobyta przez Hiszpanów stolica Tenochtitlan liczyła ponad 200 tyś osób.

Dzięki przewadze technologicznej w postaci broni palnej, dział, czy stalowych zbroi, ale także fortelowi, dzięki któremu najeźdźcy dostali się do serca stolicy i pojmali władcę Azteków - Montezumę, te liczby wystarczyły do rzucenia na kolana tubylców.

Czy podobny los czeka nas w zderzeniu z inteligentnym, wyposażonym w narzędzia i przebiegłość sztucznym tworem, który właśnie powstaje?

Czemu ta asymetria miałaby się rozegrać inaczej?

Neandertalczyków już nie ma, ale ich geny wciąż żyją w niektórych z nas. Badania genetyczne wykazały, że współcześni ludzie poza Afryką mają w swoim DNA od 1% do 2% materiału genetycznego pochodzącego od neandertalczyków. Marne to pocieszenie, że przyszła AI będzie nosiła w sobie np. 2% naszego pierwiastka.

Na koniec - jakie mam w ogóle prawo się o tym wypowiadać?

Może właśnie najwyższy czas, żeby o sprawie wypowiadali się politolodzy, filozofowie, socjolodzy, antropologowie a nie inżynierowie. Ci ostatni potrafią zaprojektować przełomowe technologie, trudno jednak żeby umieli przewidzieć społeczne skutki ich szerokiego użycia. Noah Smith w świetnym artykule "It's probably the phones" opisuje następstwa społeczne pojawienia się na rynku smartfonów. Mocne.

Przed nami takie samo wyzwanie do potęgi n.

(Wszystkie zdjęcia w tekście wygenerowałem przy pomocy Midjourney)